Die Halbleiterindustrie entwickelt sich ständig weiter, um den steigenden Anforderungen nach höherer Leistung und Effizienz gerecht zu werden. Zwei der wichtigsten Innovationen in diesem Bereich sind High Bandwidth Memory (HBM) und 3D Stacking1 . Zwar sind beide Technologien längst nicht mehr „neu“ (HBM wurde 2013 auf den Markt gebracht, 3D Stacking gar in den frühen 2000ern Jahren entwickelt), durch die wahnsinnig steigende Nachfrage nach kompakteren und leistungsfähigeren Chips hat sie aber erheblich an Bedeutung gewonnen2.

Die steigende Nachfrage nach HBM und 3D Stacking, lässt sich unter anderem auf den Boom bei Anwendungen der Künstlichen Intelligenz (KI) und Hochleistungsrechnern (HPC) zurückzuführen. Laut einer Studie von IDC wird erwartet, dass der Markt für HBM und verwandte Technologien bis 2024 eine jährliche Wachstumsrate von über 20% erreichen wird3.

Was ist 3D Stacking?

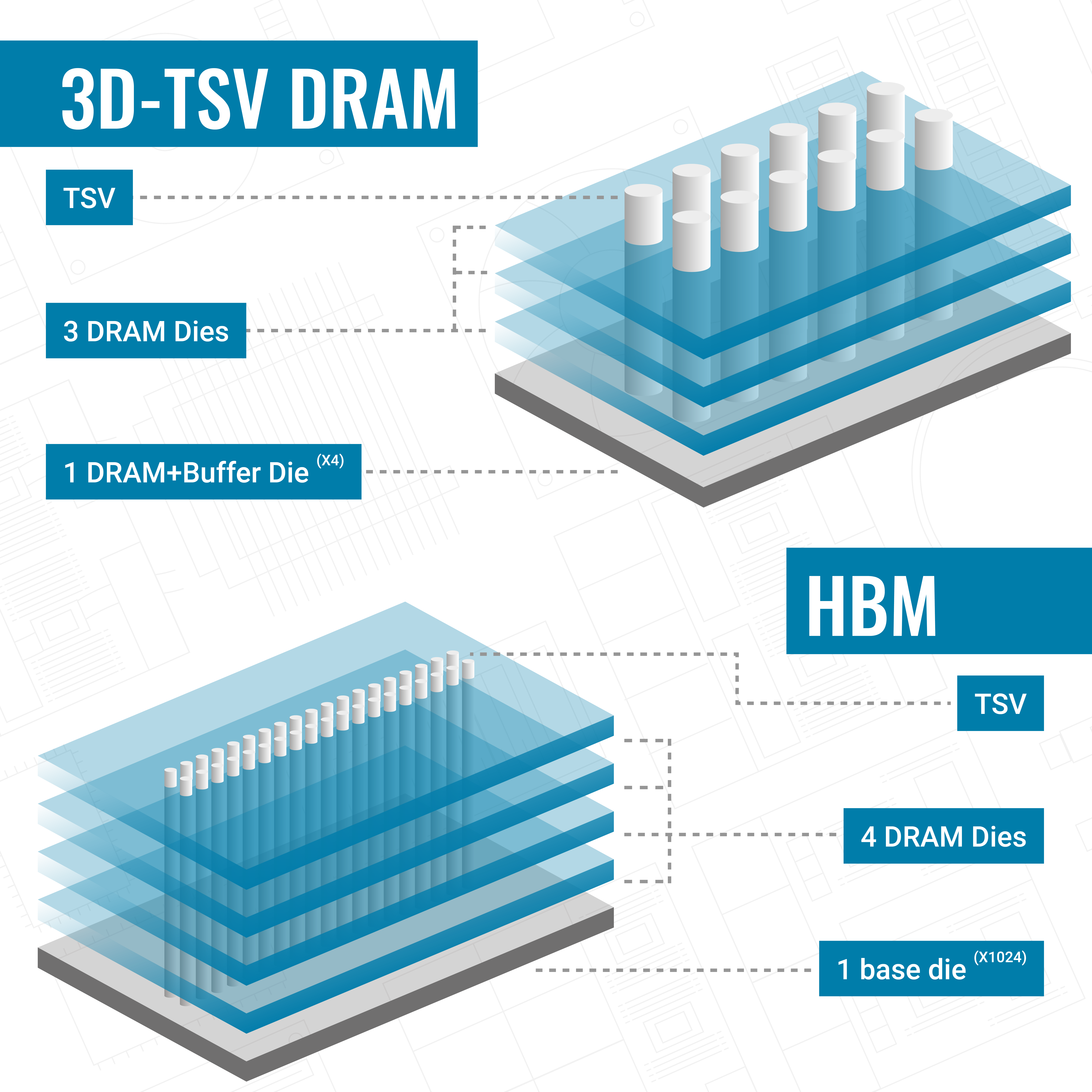

3D Stacking ist eine Technologie, bei der mehrere Halbleiterchips übereinander gestapelt und durch vertikale Verbindungen, sogenannte "Through-Silicon Vias" (TSVs), miteinander verbunden werden. Diese Technik ermöglicht eine erhebliche Reduzierung der Latenz und eine Erhöhung der Bandbreite, da die Signale nur kurze Wege zurücklegen müssen.

„Traditionelle“ Anordnung von Halbleiterchips

Üblicherweise werden Halbleiterchips nebeneinander auf einer Leiterplatte (PCB) angeordnet. Diese Anordnung erfordert längere Verbindungswege zwischen den Chips und dem Speichercontroller oder Prozessor, was zu höheren Latenzzeiten und einem erhöhten Energieverbrauch führt. Zudem nimmt diese horizontale Anordnung mehr Platz ein, was die Miniaturisierung und Leistungsdichte von elektronischen Geräten begrenzt.

Vorteile von 3D Stacking:

- Erhöhte Leistung:

Durch die vertikale Integration der Chips können Signallaufzeiten minimiert und die Leistung verbessert werden. - Platzersparnis:

Die Stapelung mehrerer Chips übereinander spart Platz und ermöglicht kompaktere Designs. - Energieeffizienz:

Wie bei HBM reduziert die Nähe der Chips zueinander den Energieverbrauch.

3D Stacking wird in verschiedenen Bereichen eingesetzt, darunter in der Speichertechnologie, bei Prozessoren und bei speziellen AI-Chips. Diese Technologie ist besonders relevant für Anwendungen, die hohe Leistungsanforderungen haben und gleichzeitig kompakte und energieeffiziente Lösungen benötigen.

1https://kpmg.com/us/en/articles/2024/global-semiconductor-industry-outlook.html2https://www2.deloitte.com/us/en/pages/technology-media-and-telecommunications/articles/semiconductor-industry-outlook.html

3https://www.idc.com/getdoc.jsp?containerId=prAP51603223

Was ist High Bandwidth Memory (HBM)?

High Bandwidth Memory (HBM) ist eine fortschrittliche Form des DRAM-Speichers, die entwickelt wurde, um eine höhere Bandbreite und Energieeffizienz zu bieten als traditionelle DRAM-Module.

Ein herkömmliches DRAM-Modul besteht aus mehreren Speicherchips, die – wie oben bereits erläutert - horizontal auf einer Leiterplatte (PCB) angeordnet sind. Diese Anordnung führt zu längeren Verbindungswegen zwischen den Chips und dem Speichercontroller, was die Datenübertragungsgeschwindigkeit einschränken und den Energieverbrauch erhöhen kann.

HBM verwendet hingegen vertikale Stapel von Speicherchips, die durch sogenannte "Through-Silicon Vias" (TSVs) miteinander verbunden sind. Dies ermöglicht eine größere Nähe der Chips zueinander und somit kürzere Verbindungswege, was die Datenübertragungsgeschwindigkeit erhöht und den Energieverbrauch senkt.

Kurz und knapp: HBM und 3D Stacking

- 3D Stacking:

Übereinander gestapelte Halbleiterchips, verbunden durch TSVs. - HBM:

Vertikale Stapelung von DRAM-Chips, verbunden durch TSVs. - Vorteile:

Höhere Leistung, Platzersparnis, Energieeffizienz. - Einsatzbereiche:

Speichertechnologie, Prozessoren, AI-Chips, HPC.

HBM Technologien, Relevanz und Verfügbarkeit

High Bandwidth Memory (HBM) hat sich als eine Schlüsseltechnologie im Speichermarkt etabliert, insbesondere im Bereich der Hochleistungsrechner (HPC) und künstlichen Intelligenz (KI). Durch seine hohe Bandbreite und Energieeffizienz ermöglicht HBM eine signifikante Leistungssteigerung bei gleichzeitiger Reduzierung des Energieverbrauchs. Diese Eigenschaften machen HBM ideal für Anwendungen, die große Datenmengen schnell verarbeiten müssen, wie zum Beispiel in Supercomputern, AI-Beschleunigern und fortschrittlichen Grafikprozessoren (GPUs)4 .

4https://www.hpcwire.com/2024/03/06/memcon-2024-insights-into-cxl-hbm-genai-and-more/Relevanz und Verfügbarkeit von HBM

High Bandwidth Memory (HBM) hat sich als eine äußerst relevante Technologie etabliert, insbesondere in Bereichen wie künstlicher Intelligenz (KI) und Hochleistungsrechnern (HPC). Führende Cloud-Anbieter wie Amazon Web Services (AWS) und Google nutzen bereits HBM in ihren Cloud-Diensten und spezialisierten Rechenressourcen, um die hohe Rechenleistung und Effizienz zu bieten, die moderne Anwendungen erfordern5,6.

HBM findet bislang vor allem Anwendung in absoluten High-End-Produkten wie NVIDIA's H200 GPUs und AMD's Radeon Instinct MI100 und MI200. Zum aktuellen Zeitpunkt ist HBM jedoch nicht in Form von Standalone-Modulen für den direkten Kauf verfügbar. Es gibt derzeit keine Ankündigungen von Herstellern, dass solche Module in naher Zukunft auf den Markt kommen werden. Die Entwicklung und Produktion von HBM konzentrieren sich derzeit auf die Integration in spezialisierte Hochleistungsprodukte.

Obwohl die Verfügbarkeit von HBM für den breiten Markt derzeit eingeschränkt ist, sollte man den HBM-Hype ernst nehmen und die Entwicklungen im Auge behalten. Diese Technologien sind primär in spezialisierten Anwendungen und bei großen Anbietern wie AWS und Google zu finden, die oft Vorreiter bei der Einführung neuer Technologien sind. Es ist daher wichtig, diese Entwicklungen zu verfolgen, um auf zukünftige Trends und Innovationen vorbereitet zu sein.

5https://www.trendforce.com/news/2024/01/30/news-latest-updates-on-hbm-from-the-leading-three-global-memory-manufacturers/6https://www.sammobile.com/news/samsung-shinebolt-hbm3e-memory-hbm4-development/